ログシーケンス埋め込みを使用したトランスフォーマーベースの異常検出

リンク一覧

概要

1 はじめに

2 背景と関連研究

2.1 ログベースの異常検出タスクの様々な定式化

2.2 教師あり学習 対 教師なし学習

2.3 ログデータ内の情報

2.4 固定ウィンドウグループ化

2.5 関連研究

3 設定可能なトランスフォーマーベースの異常検出アプローチ

3.1 問題の定式化

3.2 ログの解析とログの埋め込み

3.3 位置的および時間的エンコーディング

3.4 モデル構造

3.5 教師あり二値分類

4 実験セットアップ

4.1 データセット

4.2 評価指標

4.3 様々な長さのログシーケンスの生成

4.4 実装の詳細と実験環境

5 実験結果

5.1 RQ1: 提案する異常検出モデルはベースラインと比較してどのように性能を発揮するか?

5.2 RQ2: ログシーケンス内の順序情報と時間情報は異常検出にどの程度影響するか?

5.3 RQ3: 異なるタイプの情報は個別に異常検出にどの程度貢献するか?

6 考察

7 妥当性への脅威

8 結論と参考文献

\

3 設定可能なトランスフォーマーベースの異常検出アプローチ

本研究では、異常検出のための新しいトランスフォーマーベースの手法を紹介します。このモデルはログシーケンスを入力として異常を検出します。モデルは事前学習済みのBERTモデルを使用してログテンプレートを埋め込み、ログメッセージ内の意味情報の表現を可能にします。これらの埋め込みは、位置的または時間的エンコーディングと組み合わせて、トランスフォーマーモデルに入力されます。組み合わされた情報は、その後のログシーケンスレベルの表現生成に利用され、異常検出プロセスを促進します。私たちのモデルは柔軟に設計されています:入力特徴は設定可能であり、ログデータの異なる特徴の組み合わせを使用したり実験したりすることができます。さらに、モデルは様々な長さの入力ログシーケンスを処理するように設計され、訓練されています。このセクションでは、問題の定式化と私たちの手法の詳細な設計について紹介します。

\ 3.1 問題の定式化

私たちは先行研究[1]に従い、タスクを二値分類タスクとして定式化します。この中で、提案モデルを教師あり方式でログシーケンスを異常と正常に分類するように訓練します。モデルの訓練と評価に使用されるサンプルについては、柔軟なグループ化アプローチを利用して様々な長さのログシーケンスを生成します。詳細はセクション4で紹介します

\ 3.2 ログの解析とログの埋め込み

私たちの研究では、事前学習済み言語モデルでログテンプレートをエンコードすることにより、ログイベントを数値ベクトルに変換します。ログテンプレートを取得するために、広く使用されており、ほとんどの公開データセット[4]で良好な解析性能を持つDrainパーサー[24]を採用しています。ログ解析プロセスで生成されたログテンプレートを埋め込むために、事前学習済みのsentence-bertモデル[25](つまり、all-MiniLML6-v2 [26])を使用します。事前学習モデルは対照学習の目的で訓練され、様々なNLPタスクで最先端の性能を達成しています。私たちはこの事前学習モデルを使用して、ログメッセージの意味情報を捉え、下流の異常検出モデルのためのログテンプレート間の類似性を示す表現を作成します。モデルの出力次元は384です。

\ 3.3 位置的および時間的エンコーディング

元のトランスフォーマーモデル[27]は、モデルが入力シーケンスの順序を利用できるようにするために位置エンコーディングを採用しています。モデルには再帰も畳み込みも含まれていないため、位置エンコーディングがなければモデルはログシーケンスを認識できません。明示的な位置エンコーディングのないトランスフォーマーモデルが、シーケンシャルデータを扱う際に標準モデルと競争力を維持するという研究もありますが[28, 29]、入力シーケンスのどのような置換でもモデルの内部状態は同じになることに注意することが重要です。シーケンシャル情報や時間情報はログシーケンス内の異常の重要な指標となる可能性があるため、トランスフォーマーモデルに基づく先行研究では、シーケンス内のログイベントやテンプレートの順序を注入するために標準的な位置エンコーディングを利用しています[11, 12, 21]。これは、誤った実行順序に関連する異常を検出することを目的としています。しかし、一般的に使用されているトランスフォーマーベースの手法の複製実装[5]では、実際には位置エンコーディングが省略されていることに気づきました。私たちの知る限り、異常検出手法のためにログのタイムスタンプに基づいて時間情報をエンコードした既存の研究はありません。異常検出タスクにおけるシーケンシャル情報や時間情報の活用の有効性は不明確です。

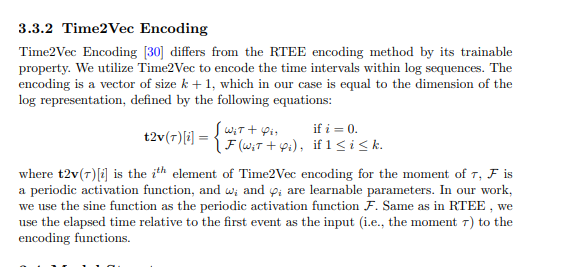

\ 提案手法では、シーケンシャルおよび時間的エンコーディングをトランスフォーマーモデルに組み込み、異常検出のためのシーケンシャル情報と時間情報の重要性を探ります。具体的には、提案手法には以下のシーケンシャルまたは時間的エンコーディング技術を利用する異なるバリアントがあります。エンコーディングはログ表現に追加され、トランスフォーマー構造への入力として機能します。

\

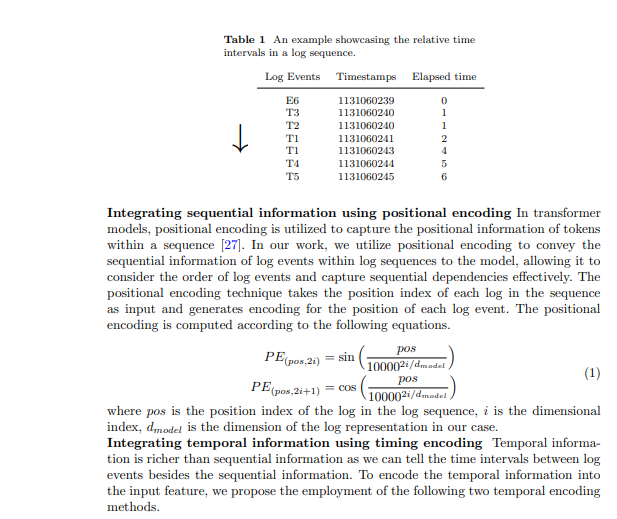

3.3.1 相対時間経過エンコーディング(RTEE)

私たちはこの時間的エンコーディング方法であるRTEEを提案します。これは単に位置エンコーディングの位置インデックスを各ログイベントのタイミングで置き換えるものです。まず、ログシーケンス内のログイベントのタイムスタンプに従って時間経過を計算します。正弦波と余弦波の方程式の位置としてログイベントシーケンスインデックスを使用する代わりに、ログシーケンス内の最初のログイベントからの相対的な時間経過を使用して位置インデックスを置き換えます。表1はログシーケンス内の時間間隔の例を示しています。この例では、7秒の時間範囲を持つ7つのイベントを含むログシーケンスがあります。シーケンス内の最初のイベントから各イベントまでの経過時間は、対応するイベントの時間エンコーディングを計算するために利用されます。位置エンコーディングと同様に、エンコーディングは上記の方程式1で計算され、トレーニングプロセス中に更新されません。

\

3.4 モデル構造

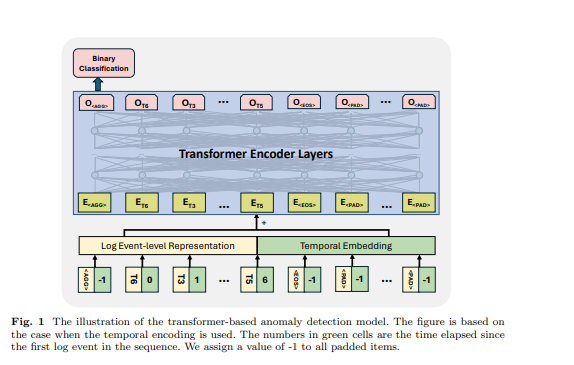

トランスフォーマーは、シーケンス内の入力要素間の関係を捉えるためにセルフアテンションメカニズムに依存するニューラルネットワークアーキテクチャです。トランスフォーマーベースのモデルとフレームワークは、多くの先行研究[6, 11, 12, 21]によって異常検出タスクに使用されています。先行研究に触発され、私たちは異常検出のためにトランスフォーマーエンコーダーベースのモデルを使用します。私たちのアプローチは、様々な長さのログシーケンスを受け入れ、シーケンスレベルの表現を生成するように設計されています。これを達成するために、BERTモデル[31]の設計からインスピレーションを得て、モデルがシーケンス表現を生成し、パディングトークンとログシーケンスの終わりを識別するための入力ログシーケンス内の特定のトークンをいくつか採用しています。入力ログシーケンスでは、以下のトークンを使用しました:シーケンスの先頭に配置され、モデルがシーケンス全体の集約情報を生成できるようにするもの、シーケンスの終わりに追加されてその完了を示すもの、自己教師あり学習パラダイムの下でマスクされたトークンをマークするために使用されるもの、そしてパディングトークンに使用されるものです。これらの特殊トークンの埋め込みは、使用されるログ表現の次元に基づいてランダムに生成されます。図1に例が示されており、、および の経過時間は-1に設定されています。ログイベントレベルの表現と位置的または時間的埋め込みは、トランスフォーマー構造の入力特徴として合計されます。

\ 3.5 教師あり二値分類 この訓練目的の下で、私たちはトランスフォーマーモデルの最初のトークンの出力を利用し、他のトークンの出力は無視します。この最初のトークンの出力は、BERTモデルのトークンと同様に、入力ログシーケンス全体の情報を集約するように設計されており、トークンシーケンスの集約表現を提供します。したがって、このトークンの出力をシーケンスレベルの表現と見なします。私たちはこの表現を用いて二値分類目的(つまり、バイナリクロスエントロピー損失)でモデルを訓練します。

\

:::info 著者:

- Xingfang Wu

- Heng Li

- Foutse Khomh

:::

:::info この論文はarxivで入手可能であり、CC by 4.0 Deed(Attribution 4.0 International)ライセンスの下で公開されています。

:::

\

関連コンテンツ

NEARは2026年に向けて静かなブレイクアウトの準備をしているのか?

ジョシュア・ウォレス、価値観に基づくリーダーシップで現代犯罪の課題に立ち向かう