L'enquête sur les soins de santé au Canada s'intensifie alors que les erreurs du rapport Deloitte soulèvent de nouvelles préoccupations concernant l'IA dans les travaux politiques

L'examen minutieux de la recherche en politique publique s'intensifie après la découverte d'erreurs dans le rapport Deloitte lors d'une révision très médiatisée des soins de santé canadiens.

Comment les problèmes liés à l'IA sont-ils apparus dans l'examen des soins de santé de Terre-Neuve-et-Labrador?

Une analyse des soins de santé commandée par le gouvernement canadien à Deloitte, coûtant près de 1,6 million de dollars, contient des inexactitudes apparemment générées par l'IA, selon une enquête de The Independent. Le document de 526 pages, publié par le gouvernement de Terre-Neuve-et-Labrador en mai, représente l'un des contrats de consultation les plus coûteux récemment dans le secteur de la santé de la province.

Le rapport a été préparé pour le ministère de la Santé et des Services communautaires alors dirigé par les Libéraux. Il examinait les soins virtuels, les mesures incitatives de rétention et l'impact de la pandémie de COVID-19 sur les travailleurs de la santé, à un moment où Terre-Neuve-et-Labrador fait face à de graves pénuries d'infirmières et de médecins. Cependant, l'examen médiatique ultérieur a soulevé des questions sur la fiabilité des preuves qui sous-tendent ces recommandations.

The Independent, un média progressiste axé sur la province la plus à l'est du Canada, a découvert de multiples inexactitudes et anomalies potentielles. De plus, son enquête suggère que certaines des citations de recherche sous-jacentes pourraient avoir été produites ou déformées avec l'aide d'outils d'intelligence artificielle, même si le récit principal n'était pas rédigé par machine.

Quels types d'erreurs dans le rapport sur les soins de santé canadiens les enquêteurs ont-ils découverts?

Selon The Independent, le rapport Deloitte incluait de fausses citations académiques qui référençaient des articles scientifiques inventés. Ces sources fictives ont été utilisées pour soutenir des analyses coût-efficacité, un élément crucial dans l'élaboration des décisions de dépenses en soins de santé. Le rapport attribuait également à tort des chercheurs réels à des études sur lesquelles ils n'avaient jamais travaillé, créant l'apparence de preuves solides là où il n'en existait pas.

Certaines citations allaient plus loin, décrivant des articles prétendument co-écrits par des chercheurs qui ont affirmé n'avoir jamais collaboré. Cela dit, l'examen n'a pas prétendu que chaque référence était défectueuse. Au lieu de cela, la préoccupation se concentre sur un modèle de problèmes de citation qui pourrait miner la confiance dans les conclusions du rapport concernant la dotation en personnel, les soins virtuels et la réforme du système.

Le rapport citait également un article supposément publié dans le Canadian Journal of Respiratory Therapy. Cependant, les enquêteurs n'ont pas pu localiser l'article dans la base de données du journal, approfondissant les craintes que des outils génératifs aient pu inventer des sources plausibles mais inexistantes.

Comment Deloitte a-t-il répondu aux allégations de citations générées par l'IA?

Dans une déclaration à Fortune, un porte-parole de Deloitte Canada a défendu le fond du travail. "Deloitte Canada soutient fermement les recommandations avancées dans notre rapport," a déclaré le porte-parole. "Nous révisons le rapport pour apporter un petit nombre de corrections de citations, qui n'ont pas d'impact sur les conclusions du rapport."

Le porte-parole a ajouté que l'intelligence artificielle n'avait pas produit le rapport écrit lui-même. Au lieu de cela, ils ont dit que l'IA avait été "utilisée sélectivement pour soutenir un petit nombre de citations de recherche." Cependant, étant donné l'ampleur de l'étude sur les soins de santé et les enjeux financiers, les critiques soutiennent que même une dépendance limitée aux références générées par machine exige une vérification et une transparence beaucoup plus strictes.

De plus, la position de l'entreprise selon laquelle les corrections de citations n'affectent pas les conclusions du rapport a suscité un examen minutieux. Certains universitaires et décideurs politiques se demandent comment des recherches fabriquées ou mal attribuées peuvent être corrigées sans réévaluer les modèles de rentabilité en aval ou les projections de main-d'œuvre.

Que disent les chercheurs concernés à propos du processus de vérification des faits de la société de conseil?

Gail Tomblin Murphy, professeure adjointe à l'École des sciences infirmières de l'Université Dalhousie en Nouvelle-Écosse, figurait parmi ceux incorrectement cités. Elle a déclaré à The Independent que Deloitte l'avait référencée dans un article académique qui "n'existe pas". Elle a noté qu'elle n'avait jamais travaillé qu'avec trois des six autres auteurs attribués dans la fausse citation, et non avec l'ensemble du groupe décrit.

"Cela semble indiquer que s'ils produisent des choses comme celles-ci, ils utilisent peut-être très largement l'IA pour générer du travail", a déclaré Tomblin Murphy. Ses commentaires soulignent le malaise croissant dans la communauté académique concernant la façon dont les outils génératifs peuvent fabriquer des bibliographies convaincantes mais inexactes, surtout lorsque les consultants ne vérifient pas rigoureusement chaque référence.

Elle a en outre averti que les rapports guidant les politiques publiques doivent être soutenus par des preuves validées et de haute qualité. De plus, Tomblin Murphy a souligné que les gouvernements et le public paient des sommes importantes pour de tels travaux, donc ils doivent être "précis, fondés sur des preuves et utiles pour faire avancer les choses." Sa critique souligne une rupture perçue dans la diligence raisonnable plutôt qu'une simple erreur technique.

Combien a coûté le rapport commandé par le gouvernement, et quelles sont les retombées politiques?

Selon une demande d'accès à l'information publiée dans un billet de blog mercredi dernier, le gouvernement canadien a payé un peu moins de 1,6 million de dollars pour l'étude Deloitte, émise en huit versements. Lundi, le rapport était toujours disponible sur le site web du gouvernement de Terre-Neuve-et-Labrador, malgré la controverse émergente concernant ses références et sa méthodologie.

Le leadership politique dans la province a changé depuis la livraison du rapport. Tony Wakeham, leader du Parti progressiste-conservateur de Terre-Neuve-et-Labrador, a été assermenté comme nouveau premier ministre de la province fin octobre. Cependant, ni le bureau du premier ministre ni le ministère de la Santé et des Services communautaires n'ont répondu immédiatement aux questions de Fortune concernant le rapport de mai, et ils n'ont pas abordé publiquement les préoccupations à ce jour.

Ce silence laisse des questions ouvertes quant à savoir si les recommandations du rapport continueront à guider la politique de santé. Il soulève également la perspective d'un examen plus approfondi par les législateurs provinciaux ou les organismes de surveillance fédéraux sur la façon dont la recherche des sociétés de conseil est vérifiée avant d'influencer les services publics essentiels.

Comment ces erreurs du rapport Deloitte se comparent-elles au cas de l'aide sociale australienne?

Les révélations canadiennes suivent des problèmes similaires en Australie. En juillet, Deloitte a produit un rapport de 290 000 dollars pour aider le gouvernement australien à renforcer la conformité de l'aide sociale. L'étude de 237 pages s'appuyait également sur la technologie générative et il a été découvert plus tard qu'elle contenait des "hallucinations", y compris des références à des recherches académiques inexistantes et une citation fabriquée d'un jugement de la cour fédérale.

Après qu'un chercheur ait signalé les problèmes, Deloitte a publié une version révisée de l'étude australienne. Le rapport mis à jour, discrètement téléchargé le mois dernier sur le site web du gouvernement, reconnaissait que l'entreprise avait utilisé le système de langage génératif Azure OpenAI pour aider à créer le document initial. Cet aveu n'est venu qu'après que l'examen externe ait exposé les citations défectueuses.

Dans le rapport australien mis à jour, Deloitte a écrit que "les mises à jour effectuées n'ont aucun impact et n'affectent pas le contenu substantiel, les conclusions et les recommandations du rapport." Cependant, les critiques ont fait valoir que les sources fabriquées jettent intrinsèquement le doute sur l'intégrité de toutes les recommandations fondées sur des preuves, pas seulement sur des détails cosmétiques. De plus, ce second épisode a intensifié le débat sur les hallucinations de l'IA de Deloitte et la robustesse de la vérification interne des faits de l'entreprise.

Quelles conséquences financières Deloitte a-t-il subies, et qu'est-ce qui reste non résolu pour le Canada?

Dans le cadre de l'affaire australienne, la société membre locale de Deloitte a été tenue de fournir au gouvernement fédéral un remboursement partiel pour le rapport défectueux sur l'aide sociale. Cette pénalité financière a signalé que les responsables considéraient les inexactitudes liées à l'IA comme suffisamment graves pour justifier une compensation.

En revanche, aucune information n'a encore été rendue publique concernant un éventuel remboursement ou recours contractuel lié au rapport canadien sur les soins de santé. Cela dit, la pression pourrait s'accroître à mesure que les décideurs politiques, les travailleurs de la santé et les contribuables se demandent s'ils ont reçu la pleine valeur d'une étude qui nécessite maintenant des corrections post-publication de sa base de preuves.

Plus largement, les deux épisodes mettent en évidence les risques croissants lorsque les gouvernements s'appuient sur de grandes sociétés de conseil utilisant la technologie générative sans garanties rigoureuses. Ils suggèrent également que les institutions publiques auront besoin de normes plus strictes pour vérifier les sources, en particulier dans les rapports de politique longs et complexes qui peuvent façonner des services critiques pendant des années.

En résumé, l'examen en cours de la révision des soins de santé canadiens par Deloitte et de l'étude australienne sur l'aide sociale souligne le besoin urgent de preuves fiables, d'une méthodologie transparente et d'une surveillance robuste chaque fois que la recherche assistée par l'IA informe les décisions de politique publique.

Vous aimerez peut-être aussi

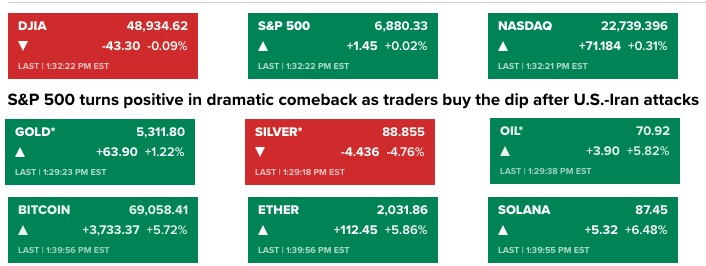

Le Bitcoin approche les 70 000 $ alors que l'escalade militaire entre les États-Unis et l'Iran provoque une volatilité macroéconomique

La CFTC nomme un ancien procureur du SDNY et défenseur des actifs numériques comme nouveau chef de l'application de la loi