Du cloud au bureau : 3 signes que la révolution de l'IA devient locale

Ces dernières années, le récit dominant a été clair : l'intelligence artificielle de pointe est le domaine exclusif de quelques géants technologiques. Cette histoire est celle de modèles massifs basés sur le Cloud computing, entraînés sur des montagnes de données dans d'immenses centres de données énergivores ; un jeu auquel seuls les plus grands acteurs pouvaient se permettre de jouer.

Mais un contre-récit significatif prend forme. Un changement puissant est en cours, déplaçant la puissance de calcul des serveurs cloud centralisés vers les ordinateurs de bureau des développeurs individuels, des chercheurs et des startups. Nous assistons à "La Grande Désagrégation" de l'IA, où les modèles monolithiques et généralistes commencent à céder la place à un écosystème de solutions spécialisées, efficaces et adaptées localement.

Ce n'est pas simplement une tendance mineure ; c'est un changement fondamental concernant qui peut construire l'avenir de l'IA et où cette construction se produit. Voici les trois signes les plus marquants de cette nouvelle ère.

Enseignement 1 : Le superordinateur sur votre bureau est désormais une réalité

La démocratisation de l'IA commence par l'accès à du matériel puissant, et cet accès vient de faire un bond en avant gigantesque. NVIDIA a récemment lancé le DGX Spark, un appareil qui, selon l'annonce, a été nommé par TIME comme l'une des meilleures inventions de 2025. C'est un véritable superordinateur avec une "empreinte plus petite qu'un smartphone", mais suffisamment puissant pour affiner des modèles comptant jusqu'à 70 milliards de paramètres, le tout sans nécessiter de connexion au cloud. C'est un défi direct au modèle économique centré sur le cloud qui a défini la dernière décennie du développement de l'IA.

Ce seul élément matériel change fondamentalement la donne pour un large éventail d'utilisateurs :

\

- Développeurs : Peuvent désormais affiner et tester des LLMs sans la dépense récurrente de location de GPUs.

- Startups : Peuvent innover et livrer des produits plus rapidement sans le fardeau des coûts cloud imprévisibles et paralysants.

- Chercheurs : Gagnent une indépendance de calcul critique, permettant une expérimentation plus flexible.

- Gouvernements : Maintiennent la souveraineté des données pour les programmes nationaux.

- Produits Edge : Exécutent une véritable IA localement, avec une faible latence, sans fuites de données.

Un prix potentiel d'environ 4 000 $ souligne le changement sismique en matière d'accessibilité, montrant clairement comment un investissement modeste pourrait être la première étape vers un accord d'un milliard de dollars. Ce développement incarne la vision articulée par Jensen Huang de NVIDIA.

Le DGX Spark représente un tournant où le coût élevé et l'accès limité qui ont historiquement ralenti l'innovation sont en train d'être démantelés. C'est la démocratisation du matériel, mettant les outils de création directement entre les mains des créateurs.

Enseignement 2 : Le 'Bouton Facile' pour l'affinage est arrivé

Le matériel puissant n'est que la moitié de l'équation. Pour vraiment libérer son potentiel, vous avez besoin d'une couche logicielle tout aussi puissante et accessible. Entrez Tinker, une API flexible du laboratoire Thinking Machines de Mira Murati, conçue pour être le lien crucial entre le matériel local et la recherche de pointe en IA.

La fonction principale de Tinker est de permettre aux chercheurs et aux développeurs d'affiner une gamme de modèles à poids ouverts, de la série Llama aux grands modèles de mélange d'experts comme Qwen-235B-A22B, en gérant l'immense "complexité de l'entraînement distribué". La plateforme a gagné une traction immédiate, avec des groupes à Princeton, Stanford, Berkeley et Redwood Research qui l'utilisent déjà pour des projets allant des démonstrateurs de théorèmes mathématiques aux tâches de contrôle de l'IA.

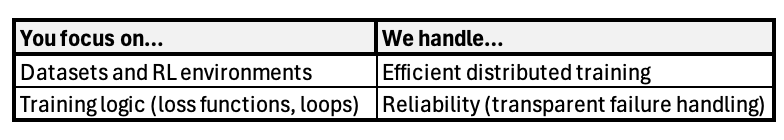

Tinker n'est pas une "boîte noire magique" ; c'est une "abstraction propre" qui crée une division claire du travail, permettant aux constructeurs de se concentrer sur ce qui rend leur travail unique, et non sur les frais généraux d'infrastructure.

Cette approche est validée par ses premiers utilisateurs. Comme le dit Tyler Griggs de Redwood Research :

C'est un exemple parfait d'adéquation produit-marché. Tinker répond à un point de douleur massif, permettant aux chercheurs brillants de se concentrer sur leurs algorithmes et leurs données tandis que la plateforme gère l'ingénierie complexe et chronophage.

Enseignement 3 : Il s'agit de progrès pratiques, pas du battage médiatique autour de l'AGI

Toute cette tendance, du DGX Spark à Tinker en passant par l'explosion des modèles open-source, pointe vers une destination claire : construire des solutions d'IA pratiques et spécialisées qui résolvent des problèmes du monde réel. Bien que ces développements soient révolutionnaires pour créer des produits utiles, ils mettent également en évidence une déconnexion croissante et conséquente dans le monde de l'IA.

Alors que l'industrie célèbre ces outils pragmatiques, beaucoup dans les communautés académiques et de recherche pure maintiennent que la véritable Intelligence Artificielle Générale (AGI) reste une perspective lointaine. Les outils que nous voyons aujourd'hui concernent le raffinement, la personnalisation et le déploiement ; pas la création d'une intelligence de niveau humain sensible à partir de zéro.

Cela prépare le terrain pour le prochain conflit majeur dans l'IA, un conflit qui concerne moins la suprématie technique et davantage la perception du marché. Ce sera une "bataille de définitions". D'un côté se trouvent les entités commerciales et leurs bailleurs de fonds en capital-risque, qui pourraient être tentés de redéfinir "AGI" pour s'adapter aux capacités impressionnantes de leurs produits actuels. De l'autre côté se trouve la communauté académique, qui adhère à un benchmark plus rigoureux et scientifique pour l'AGI. Le progrès pratique est indéniable, mais le langage que nous utilisons pour le décrire devient un champ de bataille pour l'âme de l'industrie.

Conclusion : Le nouveau champ de bataille de l'IA est là

L'ère de l'IA monolithique et généraliste comme seul jeu en ville touche à sa fin. Un écosystème plus vibrant, décentralisé et pratique est en train de prendre sa place, alimenté par du matériel accessible et des abstractions logicielles intelligentes. Ce nouveau paysage permet à un ensemble plus large de constructeurs de créer des modèles spécialisés adaptés à des tâches spécifiques à haute valeur ajoutée.

À mesure que cela se produit, le débat central dans l'industrie évolue. La question n'est plus seulement de savoir qui peut construire le plus grand modèle, mais qui gagnera la prochaine "bataille des définitions" et façonnera notre compréhension de ce qu'est vraiment l'IA et à quoi elle sert.

L'avenir de l'IA se construit sur les ordinateurs de bureau et dans les laboratoires, et le débat sur la façon de l'appeler ne fait que commencer. J'ai déjà acheté le pop-corn.

**Podcast : **Apple & Spotify

\

Vous aimerez peut-être aussi

Représentant au commerce des États-Unis : Les accords commerciaux bilatéraux américains restent valables suite à la décision de la Cour suprême sur les tarifs douaniers.

Un expert affirme que Bitcoin est maintenant dans la phase 4 du marché à la baisse, avertit que BTC pourrait atteindre la zone des 35K à 45K